Доброго времени суток.

Не могу понять как подключиться к mpd.

Файл конфигурации:

#/home/user/.mpd/mpd.conf

music_directory "/media/two/DATA/A"

playlist_directory "/home/user/.mpd/playlist"

db_file "/home/user/.mpd/tag_cache"

log_file "/home/user/.mpd/log"

pid_file "/home/user/.mpd/pid"

state_file "/home/user/.mpd/state"

sticker_file "/home/user/.mpd/sticker.sql"

port "6600"

auto_update "yes"

password "qwerty12345@read,add,control,admin"

input {

plugin "curl"

}

audio_output {

type "alsa"

name "My ALSA Device"

mixer_type "software"

Запускаю от обычного пользователя и получаю такое сообщение:

user@host:~$ mpd -v

config_file: loading file /home/user/.mpd/mpd.conf

Mar 29 19:54 : exception: bind to '0.0.0.0:6600' failed (continuing anyway, because binding to '[::]:6600' succeeded): Failed to bind socket: Address already in use

Mar 29 19:54 : libsamplerate: libsamplerate converter 'Fastest Sinc Interpolator'

...

ncmpc клиент на этой же машине работает без проблем.

Но если попытаться подключиться MPDroid или M.A.L.P то ничего не выходит.

Что я делаю: узнаю свой ip:

user@host:~$ curl ifconfig.me

Полученный адрес и пароль даю android клиенту. Клиент пишет, что не может подключиться.

И компьютер и телефон в сети со своих симок.

вопрос при регистрации на disroot.org

Which food you cannot stand, what's so horrible about it?

Okra не подходит. Как ответить?

Что-то я совсем в пятницу вечером затупил.

Вот есть у меня контроллер который лежит по такому пути:

/app/Http/Controllers/MoveController.php

И я могу его использовать так:

Route::get('/home', 'MoveController@index')->name('home');

Но мне нужно разместить этот контроллер в подкаталоге. Я перемещаю его в подкаталог personalArea:

/app/Http/Controllers/personalArea/MoveController.php

И пробую его использовать так:

Route::get('/home', 'personalArea\MoveController@index')->name('home');

И мне в ответ ошибка:

Class App\Http\Controllers\personalArea\MoveController does not exist

Я пробовал в качестве разделителя и "." и «/», но толку никакого. В чем проблема?

$exec = Выполняет команду оболочки и отображает результат в conky.

Скажем я задаю команду $exec ~/sсript.sh

Но она не работает в conky

В Минт 19 есть удобная вещь как задержка автозагрузки конкретной программы я там просто выставлял 100 сек. И программа загружалась после 100 сек после того как я стартанул Минт.

В кедах я не вижу такой опции можно ли как-то настроить такую задержку автозапуска приложения на пару секунд конкретной программы?

Здравствуйте! Помогите продумать архитектуру файлопомойки. Запутался во множестве технологий, ни одну из которых раньше не использовал.

Итак, есть 3 hdd: один wd green на 2 ТБ и два wd red на 3 и 8 ТБ. Хочу устроить один надежный том на 1ТБ (цифры условные) - с дублированием на двух других дисках, один быстрый том на 3ТБ (как raid 0, тоже из трех дисков), а всё остальное - просто еще один логический том. Шифрование всего и вся. При этом надежный том должен проверять контрольные суммы данных: что бы если на одном hdd пойдут бэды, они не переползали на другие hdd.

При этом есть еще пара некритичных хотелок:

- Гибкость массива - возможность менять размеры томов, добавлять диски…

- Если вообще бывает такое, переменный размер блока в быстром томе. То есть было бы логично на wd green писать блоки меньшего размера, так как он медленнее редов, таким образом, на грине будет храниться меньше данных, чем на редах.

И еще один вопрос: правильно ли я понимаю, что какой-бы хитрой ни была конфигурация, всегда есть возможность запустить это хозяйство под виндой, просто смонтировав все разделы под линуксом в виртуальной машине, а потом смонтировать в винде средствами виртуальной машины?

Всем доброго здоровья, подскажите можно-ли реализовать такую фичу

У меня есть winhost и на нем username.

Чтобы ходить на него по ssh приходится добавлять username@адресwinhost, пароли я убрал через authorized_keys.

так вот как бы мне сделать суперхост в котором был адрес winhost и имя username. и я бы такой довольный бы писал ssh суперхост и попадал на этот убогий winhost?

Всем добра и светлых мыслей!

Есть следующая задача:

Надо принять все пакеты (юникасты, мультикасты, ...) с eth0 и передать их через eth1.

Пытаюсь использовать raw socket для eth0, но он выдаёт не только принятые, но и отправленные пакеты.

Подскажите, как это можно сделать?

Можно ли решить задачу через iptables?

Есть ли иные способы?

Сразу скажу, что мост (это который через brctl) не подходит — он не пропускает нужные мультикасты.

Он же в основном в тредах про СПО отмечался в качестве сторонника СПО. То есть, если и грубо говорил, то, как минимум, не оффтопил.

Да, я читал оффтопик-лист:

Вопросы «почему забанен $username?». Во избежание бессмысленных флеймов и провокаций. Сама причина бана указывается в профиле.

но там не указана причина. Там только:

модератором jollheef по причине: по решению тройки от 29.III.2019 г.

Если вы работали с программами, которым приходится обрабатывать очень большое количество файловых дескрипторов, например с распределенными базами данных, такими, как Elasticsearch, то вы, наверняка, сталкивались с ошибкой "too many open files в Linux". В этой небольшой статье мы разберемся, что означает эта ошибка, а также как её исправить в различных ситуациях. Ошибка too many open files Linux Дословно эта ошибка означает, что программа открыла слишком много файлов и больше ей открывать нельзя. В Linux установлены жёсткие ограничения на количество открываемых файлов для каждого процесса и пользователя. Посмотреть, сколько файлов можно открыть в вашей файловой системе, можно, выполнив команду: cat /proc/sys/fs/file-max

Запись Ошибка too many open files в Linux впервые появилась Losst.

Спустя долгое время затишья, вызванное огромным количеством работы в том числе из-за чистки хвостов после переезда с Ogre3D, команда OpenMW с радостью сообщает о релизе версии 0.45! Феноменально огромный список исправлений включает в себя не только исправления багов, но и обеспечение лучшей совместимости с плагинами и соответствия оригинальной игре.

( читать дальше... )

Собственно, в названии темы и есть описание. Олдскульная тема (закос под BeOS), XFCE. Использую приложения как из гнома, так и из кед — тулкитофобией не страдаю, и выбираю лучшее по функционалу.

Все увлечены плоскотой и материалдизайном, но я за все годы так и не нашёл чего-то лучше и красивее BeOS, потому и использую темы с закосом под неё.

Тема GTK: https://b00merang.weebly.com/beos-r5.html

Тема оконного менеджера: самописная на основе стандартной B5 из XFCE

Иконки: https://github.com/mdomlop/retrosmart-icon-theme

Шрифты: Arial без сглаживания, единственное, от чего глаза не болят. Могу выложить fontconfig, если кому надо — там подмена ряда шрифтов, разное сглаживание для разных, и прочее.

>>> Просмотр

(1920x1080,

217 Kb)

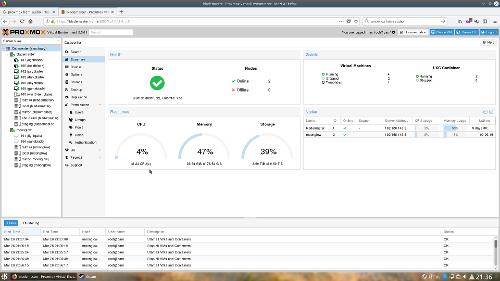

На скриншоте самый обычный проксмокс в кластере с двумя узлами, который развернут у меня дома. KDE установлен на этот же proxmox, в нем запущен firefox, а в firefox открыта веб-морда proxmox. Такая вот рекурсия.

Предыстория

Не так давно собрал себе бюджетный сервер на Xeon e5 2660v2 под хранилище виртуалок и контейнеров. К сожалению, так как потребности в вычислительных мощностях серьезно выросли за последний год, обходится парочкой Odroid-X2, как в старые добрые времена уже не могу, да и старенький HTPC на хасвелле с пассивным охлаждением с нагрузкой не всегда справляется, особенно летом.

Изначально думал собирать на TR4 1950x, но проконсультировавшись с жабой решил собрать бюджетную конфигурацию на LGA2011 и дополнить ее AMD RX580 в виде видео.

На сервере раскатал proxmox, куда мигрировал все свои виртуалки, и который мне пришелся очень по нраву. Для стима развернул виндовую виртуалку, куда пробросил физическую видеокарту.

Встал вопрос обслуживания, так как в отличие от пассивного охлаждения этого монстра надо чистить регулярно, а глушить виртуалки не всегда удобно. Именно поэтому я раскатал на десктопе еще один proxmox и объединил с основным в кластер. Графический интерфейс накатил без всяких контейнеров и виртуалок на proxmox. Все равно под капотом это привычный и любимый мною debian.

Такая конфигурация позволяет мне временно мигрировать виртуалки на десктоп без остановки системы, чтобы почистить сервер от пыли.

Конфигурация десктопа:

- i7-4560U

- 16 GB RAM

- 128GB + 256GB + 256GB SSD

Конфигурация сервера:

- Материнка X79 PlexHD ~100$

- Xeon e5 2660v2 ~100$

- 64GB DDR3 ECC RAM 1866 ~200$

- 2U корпус от Etegra (подарили, 1U БП с резервированием, бэкплейн и прочее пришлось выкинуть, а сам корпус доработать напильником и 3д-принтером.)

- 2U тихий блок питания 500W (~6.5к рублей)

- 16Gb Optane M.2 (~2.8k рублей)

Жесткие диски переместил из NAS’а и старых компов, докупать пришлось только оптанчик.

Хотя по количеству вышел (имхо) небольшой перебор:

1x1 Tb SSD для системы

2x6 Tb зеркальный рейд для данных

2х1 Tb полосатый рейд с bcache на оптане - площадка для сборки разного софта. Только при сборке на нем проектов типа OpenWRT/linux, удается выгрузить все ядра на 100%. Без кеша на оптане все упирается в I/O и больше 30-40% загрузить не выходит.

Также в новости про Stadia интересовались задержками при стриминге через steam. Собственно, дублирую замеры сюда:

На тесте было тупо главное меню subnautica:

Софтварный энкод в 6 тредов + софтовый же декод на хасвелле: 59fps@1920x1080 задержка видео 33 мс.

Софтварный энкод в 6 тредов + декодирование через QSV - 22 мс, те же 59 fps.

Аппаратный AMF энкод + декодирование через QSV - 29(!) мс.

Соединение - гигабитный линк по меди через роутер.

По количеству потоков программного кодирования: 1 поток - неиграбельно 2 потока - 50 мс и 19 fps 3 потока - 30 fps, 35 ms лаг 4 потока - 30 fps, 30 ms лаг 6 потоков - 60 fps и 21 ms лаг

Вывод: программное кодирование в большое (6+) количество потоков даст лучше и по задержкам и по качеству, чем аппаратное.

В общем как-то так. Ядра выжираются почти полностью 67% от 10 ядер судя по веб-морде проксмокса. Дополнительная погрешность от VNC и самой субнаутики.

TODO:

- Замеры энергопотребления

- Прикрутить vagrant к контейнерам proxmox

- Осилить chef

- Мигрировать все веб-приложения из виртуалок в контейнеры, попутно переписав все развертывание на chef, вместо ручной настройки. Это должно сделать автообновления всего этого добра намного проще в теории. (Сейчас там все в основном на debian stable с автоапдейтами и большей частью живет на автопилоте не требуя вмешательства, кроме ритуального обновления iredmail)

>>> Просмотр

(1920x1080,

238 Kb)

Буквально вчера перебирал Lenovo Thinkpad T530i (почистить от пыли и т.д.).

При включении сначала срабатывают все индикаторы (сама кнопка включения, кнопки выключения звука и микрофона, фонарик, индикатор диска, индикатор батареи). После этого около секунды горит индикатор диска, потом он гаснет и горят только кпонка включения и индикатор батереи. Экран не работает, никаких звуковых сигналов не слышно.

Сам ноутбук 2013 года выпуска, покупался с рук в 2017 и до этого успешно пережил замену оперативной памяти и процессора.

В чём может быть проблема?

Мне нравится мой score ~= 150. Но он постепенно увеличивается, что мне не совсем нравится.

Как его «застолбить», но без троллинга? Короче, нужен «финт ушами». Знает кто-нибудь подобное?

Добрый день. Мы в процессе перехода с nagios на prometheus (по некоторым причинам, не суть важно). В самом начале столкнулся с проблемой - в прометее вообще возможно посмотреть какие алерты привязаны к хосту (кроме как заглядывания в alerts.rules)?

Сейчас конфиг нагиоса генерим через самописный скрипт, скрипт запускается в одной из частей роли ансибла (скрипт берет переменные yaml из host_vars для построения конфига) - нам это дает, что мы можем посмотреть какие проверки привязаны к хосту как в ансбиле, так и в веб-интрефейсе нагиоса.

Yaml примерно такой:

nagios: [

"ssh", "exim", "user", "raid", "inode", "mem",

{"load": {args: ["28.0,24.0,20.0", "30.0,28.0,24.0"]}},

{certificate_port: {name: "Cert site", args: ["test.ru", 443, 15, 5], rare: 1}},

{disk: {name: "hdd-var", args: ["15%", "10%", "/dev/mapper/hdd-var"]}},

{disk: {name: "hdd-root",args: ["15%", "10%", "/dev/mapper/hdd-root"]}},

{smart: {name: "SMART sda", args: ["ata", "/dev/sda"]}},

{smart: {name: "SMART sdb", args: ["ata", "/dev/sdb"]}},

{smart: {name: "SMART sdc", args: ["ata", "/dev/sdc"]}},

{smart: {name: "SMART sdd", args: ["ata", "/dev/sdd"]}},

{mailq: {args: [5, 10]}}

]

В прометее хотим добится нечто такого же (просмотр всех проверок, привязанных к хосту), но уйти от этого костыля (питон скрипта, генерирующего конфиг).

В веб-интерфейсе прометея на вкладке Alerts можно увидель только какие алерты сейчас «горят» на каких хостах, в PromSQL по запросу ALERTS_FOR_STATE выдает в принципе тоже самое.

А хотелось бы посмотреть все проверки, даже если они в состоянии «green».

Пока идея в том, что брать переменные из host_vars и другим питон-скриптом генерировать конфиг для alert.rules . Т.е. такая информация (о всех привязанных проверках) будет видна только на уровне ансибла.

Может есть какой-то сторонний веб-интерфейс где данная проблема решена?

https://blog.golang.org/survey2018-results

Из интересного:

- Гоферы не используют винду для разработки. Чисто виндузятников всего 5%. Лидирует естественно онтопик.

- Количество вимеров прилично сократилось. Большинство использует VS Code.

- Большинство гоферов тусуется на SO, что способствует популярности во всяких рейтингах языков (того же Rust сообщества на SO фактически нет, все сидят на /r/rust).

- Большинство гоферов знают/используют в том числе Python, Java, Javasсript. Плюсовиков хоть и много, но меньше даже С. Несмотря на рассказы некоторых личностей, что все плюсовики сбежали на go.